Slutt på test av elektronikk?

Hvordan elektronikk skal testes i fremtiden er ett av temaene som ble diskutert på Testforum 2012.

Denne artikkelen er 2 år eller eldre

Det vil si, hvis det blir behov for test, da. – Under en paneldebatt på test- og målekonferansen ITC 2012 tidligere i år ble faktisk spørsmålet reist om testindustrien er døende, sier en av guruene i testbransjen, Bill Eklow fra Cisco, en av foredragsholderne på årets TestForum i regi av Nordisk TestForum (NTF), som fant sted denne uken i Snekkersten, Danmark.

Bakgrunnen for dette er ønsket om, og trenden mot, at stadig mer testfunksjonalitet bygges inn i komponentene selv. – Det skjer veldig mye på dette feltet. Men det diskuteres også hvorvidt «chip-gutta» hjelper til, eller stikker kjepper i hjulene for testindustrien, ler Eklow, som selv mener det vil være behov for både korttest og in-circuit test i overskuelig fremtid.

– Vi vil nok se endringer i typer testutstyr, i form av at vi ser mindre klassisk korttestutstyr og mer test på komponentnivå, sier Jan Heiber fra Goepel. – Korttest blir kanskje overflødig før eller siden, men ikke på lenge enda, legger han til.

Trenden er likevel klar: Komponentene blir mer og mer komplekse, og målepunktene blir færre og færre. – Det kommer mange nye testmetoder, som kjernetest og selvtest, men det vil alltid være nødvendig å kunne aksessere kortene for funksjonstest, mener Marco Barahmand fra Acculogic. Han tror imidlertid at «flying probe» type test, dvs. automatisk test med bevegelige nåler fremfor fiksturer, vil få et nytt oppsving. – Tilgangen til kortet vil nok bli mer begrenset, men det blir nok bruk av en kombinasjon av testteknikker, og mer robotisering av testen, sier han.

Med den raske utviklingen i hastighet og kompleksitet må testteknologien uansett tilpasse seg stadig nye overganger. – Instrumentene har hatt omtrent sammenfallende utvikling med Moores lov, og må holde tritt også i fremtiden. Men dette gir også en annen type utfordringer, sier Eklow. – For eksempel må vi kanskje forholde oss til at hele kretskort blir integrert i en brikke, med hva det medfører av 3D teknologi, for eksempel. Og når det gjelder overføringsteknologi nærmer vi oss en overgang til optisk båndbredde også på kretsnivå. Hvordan tilpasser vi f.eks. Boundary Scan til optiske kretser, spør han.

Eklow mener dessuten man må forholde seg mer til datainnsamling på bredere basis, og bruker begrepet datamining: – Det må innhentes enorme mengder data fra mange kilder. Det er mye jobb, men nødvendig, sier han. Dette var også tema for åpningsforedraget til Stig Lumbye fra Delta: – Selv om vi i dag utvikler kompliserte produkter, er feilene som oppstår overraskende enkle, sier Lumbye. – Er det noe vi overser? 80% av produktkostnaden ligger i designfasen, og dårlig kvalitet koster mest.

– Ved å samle mest mulig informasjon – fra egne kilder – er det mulig å avsløre skjulte kostnader ved introduksjon av nye produkter (NPI), hevder han. – Se på kvalitet, kundeklager, undersøkelser, produktivitets-KPIer, FoU og andre analyser som kan bidra til å forbedre produktet. Dette innebærer kanskje at du må endre på måten du tenker, planlegger og kostnadsestimerer NPI-prosjekter, understreker han. Og ikke minst: – Få sjefens oppmerksomhet! Få fokus på å skaffe de riktige tingene tidligere, anbefaler Lumbye, som erkjenner at testavdelingen sjelden er den mest prioriterte i produktkjeden.

– Et vanlig problem i dag er NTF – ingen feil funnet. Det vil si at produktet passerer testingen men feiler hos kunden. I tillegg lar feilene seg sjelden reprodusere, sier Artur Jutman fra Universitetet i Tallin. – Så kan man spørre hvem som er ansvarlig; er det dårlig kortdesign eller dårlig brikkedesign? Eller er det defekt i brikken, dårlig programvare, utilstrekkelig komponenttest, forskjeller i oppførsel under test og i drift – eller en kombinasjon av disse? Uansett er det nødvendig med både prosess- og testforbedringer, understreker han.

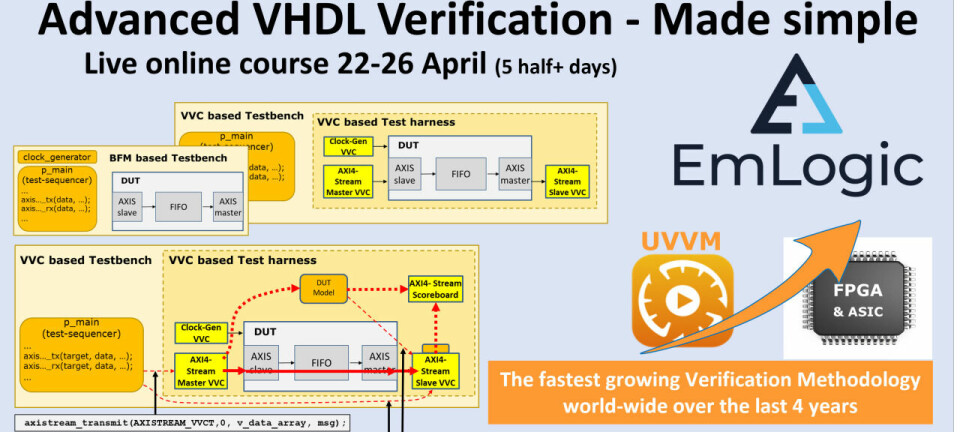

Jutman er enig i at det er blitt vanskeligere å sette testpunkter, og det er mange «svarte hull» selv med bruk av boundary scan. – Det vil også si at vi kanskje trenger en bedre måte å måle testdekning på, fremholder han. Test basert på «innvevde» instrumenter vil også være en naturlig utvikling. Instrumenter kan f.eks. lastes ned i FPGA og styres via JTAG-porten. – Det betyr at f.eks. en BERT-test kan kjøres inne i systemet, ikke eksternt. Det har flere fordeler, bl.a. mindre egenstøy, fremholder Jutman.